В прошлый раз мы с вами рассмотрели все, что касается технологии SCSI в историческом контексте: кем она была изобретена, как развивалась, какие у нее есть разновидности и так далее. Закончили мы на том, что наиболее современным и актуальным стандартом является Serial Attached SCSI, он появился относительно недавно, но получил быстрое развитие. Первую реализацию «в кремнии» показала компания LSI в январе 2004 года, а в ноябре того же года SAS вошел в топ самых популярных запросов сайта storagesearch.com. Начнем с основ. Как же работают устройства на технологи SCSI? В стандарте SCSI все построено на концепции клиент/сервер. Клиент, называемый инициатором (англ. initiator), отправляет разные команды и дожидается их результатов. Чаще всего, разумеется, в роли клиента выступает SAS контроллер. Сегодня SAS контроллеры — это HBA и RAID-контроллеры, а также контроллеры СХД, стоящие внутри внешних систем хранения данных. Сервер называется целевым устройством (англ. target), его задача — принять запрос инициатора, обработать его и вернуть данные или подтверждение выполнения команды обратно. В роли целевого устройства может выступать и отдельный диск, и целый дисковый массив. В этом случае SAS HBA внутри дискового массива (так называемая внешняя система хранения данных), предназначенный для подключения к нему серверов, работает в режиме Target. Каждому целевому устройству (“таргету”) присваивается отдельный идентификатор SCSI Target ID. Для связи клиентов с сервером используется подсистема доставки данных (англ. Service Delivery Subsystem), в большинстве случаев, это хитрое название скрывает за собой просто кабели. Кабели бывают как для внешних подключений, так и для подключений внутри серверов. Кабели меняются от поколения к поколению SAS. На сегодня имеется три поколения SAS: — SAS-1 или 3Gbit SAS — SAS-2 или 6Gbit SAS — SAS-3 или 12 Gbit SAS – готовится к выходу в середине 2013 года

Внутренние и внешние кабели SAS Иногда в состав этой подсистемы могут входить расширители или экспандеры SAS. Под экспандерами (англ. Expanders, расширители, но в русском языке прижилось слово «экспандер») понимают устройства, помогающие доставке информации от инициаторов к целям и обратно, но прозрачные для целевых устройств. Одним из самых типичных примеров является экспандер, позволяющий подключить несколько целевых устройств к одному порту инициатора, например, микросхема экспандера в дисковой полке или на бэкплейне сервера. Благодаря такой организации, серверы могут иметь более 8 дисков (контроллеры, которые сегодня используются ведущими производителями серверов, обычно 8-портовые), а дисковые полки – любое необходимое количество. Инициатор, соединенный с целевым устройством системой доставки данных, называют доменом. Любое SCSI устройство содержит как минимум один порт, который может быть портом инициатора, целевого устройства или совмещать обе функции. Портам могут присваиваться идентификаторы (PID). Целевые устройства состоят из как минимум одного логического номера устройства (Logical Unit Number или LUN). Именно LUN и идентифицирует с каким из дисков или разделов данного целевого устройства будет работать инициатор. Иногда говорят, что target предоставляет инициатору LUN. Таким образом, для полной адресации к нужному хранилищу используется пара SCSI Target ID + LUN. Как в известном анекдоте («Я не даю в долг, а Первый Национальный Банк не торгует семечками») — целевое устройство обычно не выступает в роли «посылающего команды», а инициатор — не предоставляет LUN. Хотя стоит отметить, что стандарт допускает тот факт, что одно устройство может быть одновременно и инициатором и целью, но на практике это используют мало. Для «общения» устройств в SAS существует протокол, по «доброй традиции» и по рекомендации OSI, разделенный на несколько слоев (сверху вниз): Application, Transport, Link, PHY, Architecture и Physical. SAS включает в себя три транспортных протокола. Serial SCSI Protocol (SSP) — используется для работы со SCSI устройствами. Serial ATA Tunneling Protocol (STP) — для взаимодействия с дисками SATA. Serial Management Protocol (SMP) — для управления SAS-фабрикой. Благодаря STP мы можем подключать диски SATA к контроллерам SAS. Благодаря SMP мы можем строить большие (до 1000 дисковых/SSD-устройств в одном домене) системы, а также использовать зонирование SAS (подробнее об этом в статье про SAS-коммутатор). Уровень связей служит для управления соединениями и передачи фреймов. Уровень PHY — используется для таких вещей как установка скорости соединения и кодировки. На архитектурном уровне находятся вопросы расширителей и топологии. Физический уровень определяет напряжение, форму сигналов соединения и т.д. Все взаимодействие в SCSI строится на основании команд, которые инициатор посылает целевому устройству и ожидает их результата. Команды эти посылаются в виде блоков описания команды (Command Description Block или CDB). Блок состоит из одного байта кода команды и ее параметров. Первым параметром почти всегда выступает LUN. CDB может иметь длину от 6 до 32 байт, хотя последние версии SCSI допускают CDB переменной длины. После получения команды целевое устройство возвращает код подтверждения. 00h означает что команда принята успешно, 02h обозначает ошибку, 08h — занятое устройство. Команды делятся на 4 большие категории. N, от английского «non-data», предназначены для операций, не относящихся к непосредственно обмену данными. W, от «write» — запись данных, полученных целевым устройством от инициатора. R, как не сложно догадаться от слова «read» используется для чтения. Наконец В — для двустороннего обмена данными. Команд SCSI существует достаточно много, поэтому перечислим только наиболее часто используемые. Test unit ready (00h) — проверить, готово ли устройство, есть ли в нем диск (если это ленточный накопитель), раскрутился ли диск и так далее. Стоит отметить, что в данном случае устройство не производит полной самодиагностики, для этого существуют другие команды. Inquiry (12h) — получить основные характеристики устройства и его параметры Send diagnostic (1Dh) — произвести самодиагностику устройства — результаты этой команды возвращаются после диагностики командой Receive Diagnostic Results (1Ch) Request sense (03h) — команда позволяет получить статус выполнения предыдущей команды — результатом этой команды может стать как сообщение типа «нет ошибки», так и разные сбои, начиная с отсутствия диска в накопителе и заканчивая серьезными проблемами. Read capacity (25h) — позволяет узнать объем целевого устройства Format Unit (04h) — служит для деструктивного форматирования целевого устройства и подготовки его к хранению данных. Read (4 варианта) — чтение данных; существует в виде 4 разных команд, отличающихся длиной CDB Write (4 варианта) — запись. Так же как и для чтения в 4 вариантах Write and verify (3 варианта) — запись данных и проверка Mode select (2 варианта) — установка различных параметров устройства Mode sense (2 варианта) — возвращает текущие параметры устройства А теперь рассмотрим несколько типичных примеров организации хранения данных на SAS. Пример первый, сервер хранения данных. Что это такое и с чем его едят? Большие компании типа Amazon, Youtube, Facebook, Mail.ru и Yandex используют сервера этого типа для того, чтобы хранить контент. Под контентом понимается видео, аудио информация, картинки, результаты индексирования и обработки информации (например, так популярный в последнее время в США, Hadoop), почта, и.т.д. Для понимания задачи и грамотного выбора оборудования под нее нужно дополнительно знать несколько вводных, без которых никак нельзя. Первое и самое главное – чем больше дисков – тем лучше. Дата-центр одной из российских Web 2.0-компаний Процессоры и память в таких серверах задействуются не сильно. Второе – в мире Web 2.0, информация хранится географически распределено, несколько копий на различных серверах. Хранится 2-3 копии информации. Иногда, если она запрашивается часто, хранят больше копий для балансировки нагрузки. Ну и третье, исходя из первого и второго, чем дешевле – тем лучше. В большинстве случаев все вышесказанное приводит к тому, что используются Nearline SAS или SATA диски высокой емкости. Как правило, Enterprise-уровня. Это значит, что такие диски предназначены для работы 24×7 и стоят значительно дороже своих собратьев, использующихся в настольных PC. Корпус обычно выбирают такой, куда можно вставить побольше дисков. Если это 3.5’’, то 12 дисков в 2U.

Дата-центр одной из российских Web 2.0-компаний Процессоры и память в таких серверах задействуются не сильно. Второе – в мире Web 2.0, информация хранится географически распределено, несколько копий на различных серверах. Хранится 2-3 копии информации. Иногда, если она запрашивается часто, хранят больше копий для балансировки нагрузки. Ну и третье, исходя из первого и второго, чем дешевле – тем лучше. В большинстве случаев все вышесказанное приводит к тому, что используются Nearline SAS или SATA диски высокой емкости. Как правило, Enterprise-уровня. Это значит, что такие диски предназначены для работы 24×7 и стоят значительно дороже своих собратьев, использующихся в настольных PC. Корпус обычно выбирают такой, куда можно вставить побольше дисков. Если это 3.5’’, то 12 дисков в 2U.  Типичный 2U-сервер хранения данных Или 24 x 2.5’’ в 2U. Или другие варианты в 3U, 4U и.т.д. Теперь, имея корпус, количество дисков и их тип, мы должны выбрать тип подключения. Вообще-то выбор не очень большой. А сводится он к использованию экспандерного или безэкспандерного бэкплейна. Если мы используем экспандерный бекплейн, то контроллер SAS может быть 8-портовым. Если безэкспандерный – то количество портов контроллера SAS должно равняться или превышать количество дисков. Ну и последнее, выбор контроллера. Мы знаем количество портов, 8, 16, 24, например и выбираем контроллер исходя из этих условий. Контроллеры бывают 2х типов, RAID- и HBA. Отличаются они тем, что RAID-контроллеры поддерживают уровни RAID 5,6,50,60 и имеют достаточно большой объем памяти (512MB-2ГБ сегодня) для кэширования. У HBA памяти или cовсем нет, или ее очень мало. Кроме этого, HBA либо не умеют делать RAID вообще, либо умеют олько простые, не требующие большого объема вычислений уровни. RAID 0/1/1E/10 – типичный набор для HBA. Здесь нам нужен HBA, они стоят значительно дешевле, так защита данных нам не нужна совсем и мы стремимся к минимизации стоимости сервера.

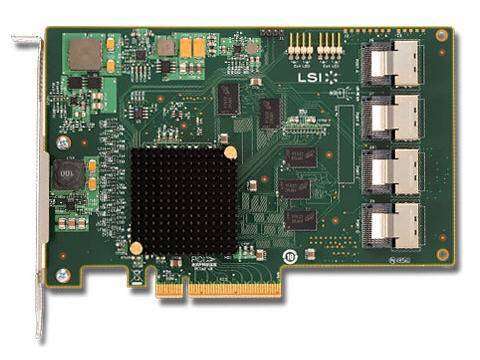

Типичный 2U-сервер хранения данных Или 24 x 2.5’’ в 2U. Или другие варианты в 3U, 4U и.т.д. Теперь, имея корпус, количество дисков и их тип, мы должны выбрать тип подключения. Вообще-то выбор не очень большой. А сводится он к использованию экспандерного или безэкспандерного бэкплейна. Если мы используем экспандерный бекплейн, то контроллер SAS может быть 8-портовым. Если безэкспандерный – то количество портов контроллера SAS должно равняться или превышать количество дисков. Ну и последнее, выбор контроллера. Мы знаем количество портов, 8, 16, 24, например и выбираем контроллер исходя из этих условий. Контроллеры бывают 2х типов, RAID- и HBA. Отличаются они тем, что RAID-контроллеры поддерживают уровни RAID 5,6,50,60 и имеют достаточно большой объем памяти (512MB-2ГБ сегодня) для кэширования. У HBA памяти или cовсем нет, или ее очень мало. Кроме этого, HBA либо не умеют делать RAID вообще, либо умеют олько простые, не требующие большого объема вычислений уровни. RAID 0/1/1E/10 – типичный набор для HBA. Здесь нам нужен HBA, они стоят значительно дешевле, так защита данных нам не нужна совсем и мы стремимся к минимизации стоимости сервера. 16-портовый SAS HBA Пример второй, почтовый сервер Exchange. А также MDaemon, Notes и другие подобные сервера. Здесь все не так очевидно, как в первом примере. В зависимости от того, сколько пользователей должен обслуживать сервер, рекомендации будут различными. В любом случае, мы знаем что базу данных Exchange (так называемую БД Jet) лучше всего хранить на RAID 5/6 и она неплохо кэшируется с использованием SSD. В зависимости от количества пользователей определяем необходимые объемы хранения «сегодня» и «на вырост». Помним, что сервер живет 3-5 лет. Поэтому «на вырост» можно ограничить 5-летней перспективой. Потом будет дешевле полностью поменять сервер. В зависимости от объема дисков выберем корпус. С бэкплейном проще, рекомендуется использовать экспандеры, так как требования по цене не такие жесткие, как в предыдущем случае, и в общем случае, удорожание сервера на $50-$100, а иногда и больше, мы вполне переживем в угоду надежности и функциональности. Диски выберем SAS или NL-SAS/Enterprise SATA в зависимости от объемов. Далее, защита данных и кэширование. Выберем современный 4/8-портовый контроллер, поддерживающий RAID 5/6/50/60 и кэширование на SSD. Для LSI, это любой MegaRAID кроме 9240 с функцией кэширования CacheCade 2.0, или Nytro MegaRAID с SSD «на борту». Для Adaptec, это контроллеры, поддерживающие MAX IQ. Для кэширования в обоих случаях (кроме Nytro MegaRAID) нужно будет взять пару SSD на e-MLC-технологии Enterprise-класса. Такие есть у Intel, Seagate, Toshiba, и.т.д. Цены и компании – на выбор. Если вы не порч доплатить за бренд, то в линейках серверов IBM, Dell, HP, найдите подобные продукты и вперед! SSD- кэширующий RAID-контроллер Nytro MegaRAID Пример третий, внешняя система хранения данных своими руками. Итак, самое серьезное знание SAS, конечно же, требуется тем, кто производит системы хранения данных или хочет их сделать своими руками. Мы остановимся на достаточно простой СХД, программное обеспечение для которой производится компанией Open-E. Конечно же, можно делать СХД и на Windows Storage Server, и на Nexenta, и на AVRORAID, и на Open NAS, и на любом другом подходящем для этих целей софте. Я просто обозначил основные направления, а дальше вам помогут сайты производителей. Итак, если это внешняя система, то мы почти никогда не знаем, сколько же дисков потребуется конечному пользователю. Мы должны быть гибкими. Для этого есть так называемые JBOD – внешние полки для дисков. В их состав входит один или два экспандера, каждый из которых имеет вход (4-х портовый разъем SAS), выход на следующий экспандер, остальные порты разведены на разъемы, предназначенные для подключения дисков. Причем, в двухэкспандерных системах первый порт диска разведен на первый экспандер, второй порт – на второй экспандер. Это позволяет строить отказоустойчивые цепочки JBOD-ов. Головной сервер может иметь внутренние диски в своем составе, либо не иметь их совсем. В этом случае используются «внешние» контроллеры SAS. То есть контроллеры с портами «наружу». Выбор между SAS RAID-контроллером или SAS HBA зависит от управляющего ПО, которое вы выбираете. В случае Open-E, это RAID-контроллер. Можно позаботиться и об опции кэширования на SSD. Если ваша СХД будет иметь очень много дисков, то решение Daisy Chain (когда каждый последующий JBOD подключается к предыдущему, либо к головному серверу) в силу многих причин не подходит. В этом случае головной сервер либо оснащается несколькими контроллерами, либо используется устройство, которое называется SAS-коммутатор. Он позволяет подключать один или несколько серверов к одному или нескольким JBOD. Подробнее SAS-коммутаторы мы разберем в следующих статьях. Для внешних систем хранения данных настоятельно рекомендуется использовать диски только SAS (в том числе NearLine) в силу повышенных требований к отказоустойчивости. Дело в том, что протокол SAS имеет в своем составе гораздо больше функций, чем SATA. Например, контроль записываемых-считываемых данных на всем пути с помощью проверочных сумм (T.10 End-to-End protection). А путь, как мы уже знаем, бывает очень длинным. Многодисковый JBOD Напоследок, хочется поделиться некоторыми сведениями о текущей адаптации SAS мировыми производителями оборудования. SAS сегодня – это стандарт де-факто для серверных систем и профессиональных рабочих станций. Серверные системы подавляющего большинства как A- так и B- брендов имеют в составе контроллеры SAS, как HBA, так и RAID. В области внешних систем хранения данных, основные производители оборудования (HP, EMC, NetApp, IBM) уже несколько лет как перевели внутренние архитектуры своих систем на SAS. Таким образом, диски Fibre Channel стали за последние пару лет настоящей экзотикой. Fibre Channel продолжает жить и развиваться, в основном, как способ подключения серверов к системам хранения данных, хотя в области Low-End, Mid-Range и профессиональных систем, SAS отвоевывает все большую долю. На этом наш экскурс в мир истории и теории SCSI вообще и SAS в частности подошел к концу, и в следующий раз я расскажу вам более подробно о применении SAS в реальной жизни. За последние годы SAS успел окончательно вытеснить параллельный SCSI и даже понемногу начал занимать территорию FibreChannel (как для подключения хостов к СХД, так и дисков). Сменилось поколение стандарта SAS, скоро появится третье поколение (статья о SAS 3.0 и Multilink SAS), выпущено большое количество оборудования, в том числе и основным для нас вендором — компанией Supermicro. Речь, конечно же, пойдет прежде всего о корпусах Supermicro с SAS-экспандерами: по-прежнему вопросы о подключении дисков или контроллеров, совместимости, производительности поступают каждый день. Причины несовместимости — от широко известного отсутствия поддержки диском SCT Error Recovery Control (он же TLER в терминологии WD, без поддержки ERC возникает ситуация, когда диск слишком долго пытается получить доступ к сбойному сектору) до фатального сочетания багов в микрокоде контроллера диска, SAS-контроллера и экспандера. Но помимо HCL (которые могут быть неполными или содержать неточности), есть следующие особенности:

16-портовый SAS HBA Пример второй, почтовый сервер Exchange. А также MDaemon, Notes и другие подобные сервера. Здесь все не так очевидно, как в первом примере. В зависимости от того, сколько пользователей должен обслуживать сервер, рекомендации будут различными. В любом случае, мы знаем что базу данных Exchange (так называемую БД Jet) лучше всего хранить на RAID 5/6 и она неплохо кэшируется с использованием SSD. В зависимости от количества пользователей определяем необходимые объемы хранения «сегодня» и «на вырост». Помним, что сервер живет 3-5 лет. Поэтому «на вырост» можно ограничить 5-летней перспективой. Потом будет дешевле полностью поменять сервер. В зависимости от объема дисков выберем корпус. С бэкплейном проще, рекомендуется использовать экспандеры, так как требования по цене не такие жесткие, как в предыдущем случае, и в общем случае, удорожание сервера на $50-$100, а иногда и больше, мы вполне переживем в угоду надежности и функциональности. Диски выберем SAS или NL-SAS/Enterprise SATA в зависимости от объемов. Далее, защита данных и кэширование. Выберем современный 4/8-портовый контроллер, поддерживающий RAID 5/6/50/60 и кэширование на SSD. Для LSI, это любой MegaRAID кроме 9240 с функцией кэширования CacheCade 2.0, или Nytro MegaRAID с SSD «на борту». Для Adaptec, это контроллеры, поддерживающие MAX IQ. Для кэширования в обоих случаях (кроме Nytro MegaRAID) нужно будет взять пару SSD на e-MLC-технологии Enterprise-класса. Такие есть у Intel, Seagate, Toshiba, и.т.д. Цены и компании – на выбор. Если вы не порч доплатить за бренд, то в линейках серверов IBM, Dell, HP, найдите подобные продукты и вперед! SSD- кэширующий RAID-контроллер Nytro MegaRAID Пример третий, внешняя система хранения данных своими руками. Итак, самое серьезное знание SAS, конечно же, требуется тем, кто производит системы хранения данных или хочет их сделать своими руками. Мы остановимся на достаточно простой СХД, программное обеспечение для которой производится компанией Open-E. Конечно же, можно делать СХД и на Windows Storage Server, и на Nexenta, и на AVRORAID, и на Open NAS, и на любом другом подходящем для этих целей софте. Я просто обозначил основные направления, а дальше вам помогут сайты производителей. Итак, если это внешняя система, то мы почти никогда не знаем, сколько же дисков потребуется конечному пользователю. Мы должны быть гибкими. Для этого есть так называемые JBOD – внешние полки для дисков. В их состав входит один или два экспандера, каждый из которых имеет вход (4-х портовый разъем SAS), выход на следующий экспандер, остальные порты разведены на разъемы, предназначенные для подключения дисков. Причем, в двухэкспандерных системах первый порт диска разведен на первый экспандер, второй порт – на второй экспандер. Это позволяет строить отказоустойчивые цепочки JBOD-ов. Головной сервер может иметь внутренние диски в своем составе, либо не иметь их совсем. В этом случае используются «внешние» контроллеры SAS. То есть контроллеры с портами «наружу». Выбор между SAS RAID-контроллером или SAS HBA зависит от управляющего ПО, которое вы выбираете. В случае Open-E, это RAID-контроллер. Можно позаботиться и об опции кэширования на SSD. Если ваша СХД будет иметь очень много дисков, то решение Daisy Chain (когда каждый последующий JBOD подключается к предыдущему, либо к головному серверу) в силу многих причин не подходит. В этом случае головной сервер либо оснащается несколькими контроллерами, либо используется устройство, которое называется SAS-коммутатор. Он позволяет подключать один или несколько серверов к одному или нескольким JBOD. Подробнее SAS-коммутаторы мы разберем в следующих статьях. Для внешних систем хранения данных настоятельно рекомендуется использовать диски только SAS (в том числе NearLine) в силу повышенных требований к отказоустойчивости. Дело в том, что протокол SAS имеет в своем составе гораздо больше функций, чем SATA. Например, контроль записываемых-считываемых данных на всем пути с помощью проверочных сумм (T.10 End-to-End protection). А путь, как мы уже знаем, бывает очень длинным. Многодисковый JBOD Напоследок, хочется поделиться некоторыми сведениями о текущей адаптации SAS мировыми производителями оборудования. SAS сегодня – это стандарт де-факто для серверных систем и профессиональных рабочих станций. Серверные системы подавляющего большинства как A- так и B- брендов имеют в составе контроллеры SAS, как HBA, так и RAID. В области внешних систем хранения данных, основные производители оборудования (HP, EMC, NetApp, IBM) уже несколько лет как перевели внутренние архитектуры своих систем на SAS. Таким образом, диски Fibre Channel стали за последние пару лет настоящей экзотикой. Fibre Channel продолжает жить и развиваться, в основном, как способ подключения серверов к системам хранения данных, хотя в области Low-End, Mid-Range и профессиональных систем, SAS отвоевывает все большую долю. На этом наш экскурс в мир истории и теории SCSI вообще и SAS в частности подошел к концу, и в следующий раз я расскажу вам более подробно о применении SAS в реальной жизни. За последние годы SAS успел окончательно вытеснить параллельный SCSI и даже понемногу начал занимать территорию FibreChannel (как для подключения хостов к СХД, так и дисков). Сменилось поколение стандарта SAS, скоро появится третье поколение (статья о SAS 3.0 и Multilink SAS), выпущено большое количество оборудования, в том числе и основным для нас вендором — компанией Supermicro. Речь, конечно же, пойдет прежде всего о корпусах Supermicro с SAS-экспандерами: по-прежнему вопросы о подключении дисков или контроллеров, совместимости, производительности поступают каждый день. Причины несовместимости — от широко известного отсутствия поддержки диском SCT Error Recovery Control (он же TLER в терминологии WD, без поддержки ERC возникает ситуация, когда диск слишком долго пытается получить доступ к сбойному сектору) до фатального сочетания багов в микрокоде контроллера диска, SAS-контроллера и экспандера. Но помимо HCL (которые могут быть неполными или содержать неточности), есть следующие особенности:

- Дисковые корзины Supermicro CSE-M28E1 и CSE-M28E2, содержащие один или два экспандера LSI SASX12, несовместимы с контроллерами Adaptec 6-й серии и контроллерами LSI MegaRAID SAS-2 (все контроллеры на базе чипов LSI 2108 и 2208): экспандер не определяется, иногда с ошибкой «Invalid SAS topology» при запуске контроллера.

SAS-экспандер и кластеры Первая идея, которая приходит в голову человеку, впервые увидевшему JBOD с двумя SAS-экспандерами: «А нельзя ли подключить два хоста с SAS RAID контроллерами к этому JBOD и использовать получившуюся конструкцию для кластера, требующего общий LUN?» Стоимость подобного решения в сравнении с готовыми 2-контроллерными СХД начального уровня выглядит привлекательно. Но, увы, работать ничего не будет*:

- Обычные RAID контроллеры не рассчитаны на такое подключение (но сейчас есть и исключения в виде LSI Syncro CS). Их firmware ничего не знает о том, как поделить доступ к дискам с другим контроллером. Если бы даже не существовало этой проблемы, то возникает проблема синхронизации кэшей и так далее. На практике вы увидите зависание одного или обоих контроллеров при инициализации, возможно с сообщением об ошибочной топологии SAS.

- Заблуждение о том, что «SAS-JBOD — это бюджетная система хранения данных» — основная логическая ошибка, которую многие почему-то не сразу замечают. JBOD — это просто корпус с дисками и SAS-экспандером, а от системы хранения данных мы должны получить готовый LUN, а не набор дисков.

- Единственное, что можно сделать с JBOD’ом подручными средствами применить зонирование, отдав каждому хосту свой набор дисков. Переключив зонирование дисков с отказавшего хоста на исправный, можно быстро получить доступ к данным, но это не решает проблему с данными, находившимися в кэше. Зонирование требует подключения дисков к SAS-2 экспандеру, а для управления зонированием можно использовать SAS-коммутатор, например, LSI 6160, которому уже были посвящены несколько статей.

*Обновление от 14.10.2013. Времена меняются, и утверждение «SAS JBOD — не для кластеров» уже теряет актуальность. С появлением поддержки Parity Spaces для Failover Cluster’а в Microsoft Windows Server 2012 R2 использование Storage Spaces для кластеров Microsoft становится вполне обоснованным. Для vSphere есть VSA и с появлением vSphere 5.5 — еще и VSAN (наследие Virsto).

SAS-экспандеры в продуктах Supermicro

Корпуса с SAS-экспандерами. Развновидностей много: от 2U до 4U, с SAS-1 или SAS-2 экспандерами, с одним или с двумя экспандерами, под SFF и LFF диски, с обычным и двухсторонним размещением дисков. Подробнее ознакомится с этим многообразием можно на сайте Supermicro. Особенности:

- 2U корпуса (и 4U с двухсторонним размещением дисков) имеют разновидности «LP» и «U» (например, SC216E26-R1200LPB и SC216E26-R1200UB). Первая предназначена для обычный плат размером до E-ATX, платы расширения — только низкопрофильные, устанавливаются напрямую, без райзера. Вторая — для системных плат форм-фактора UIO (с вырезом для размещения платы в нижний слот райзера) и позволяет устанавливать до 4-х плат полной высоты + 3-х низкопрофильных плат.

- Большинство экспандерных бэкплейнов Supermicro имеют один вход и два выхода (с разъемами 4x SAS SFF-8087) для удобства каскадирования: последовательное подключение более 6-ти экспандеров LSI крайне не желательно, а два выхода позволяют построить топологию с ответвлениями. Вот пример топологии с каскадом из двух 2-экспандерных бэкплейнов на чипе LSI SAS2X36 (12 phy экспандера — на вход и выходы, оставшиеся 24 — для подключения дисков):

- Корпуса с поддержкой более 24-х дисков содержат несколько бэкплейнов, каждый из которых — со своим экспандером. Пример: корпус 847E16-R1400LPB — это 4U корпус с двухсторонним размещением дисков. Спереди — бэкплейн SAS2-846EL1 на 24 диска (SAS2X36), сзади — SAS2-826EL1 на 12 дисков (LSI SAS2X24). Тут возникает свобода подключения: подключить первый бэкплейн к 4-портовому контроллеру и второй бэкплейн каскадом к первому, подключить оба бэкплейна к одному 8-портовому контроллеру или к разным контроллерам.

- Платы многих 2-экспандерных бэкплейнов имеют ошибочную маркировку портов второго экспандера. Например, на 826EL2 порты второго экспандера SEC_J0 и SEC_J1 (вход и выход) промаркированы наоборот. Правильную информацию нужно искать в инструкции.

- На основе корпусов Supermicro можно сделать SAS-JBOD. Для этого вместо системной платы устанавливается небольшая плата управления питанием, а входы и выходы бэкплейна выводятся наружу при помощи кабеля-переходника SFF8087->SFF8088. Более того, некоторые варианты корпусов существуют исключительно в JBOD-исполнении, системную плату просто некуда установить (417E16-RJBOD1 на 88 дисков SFF).

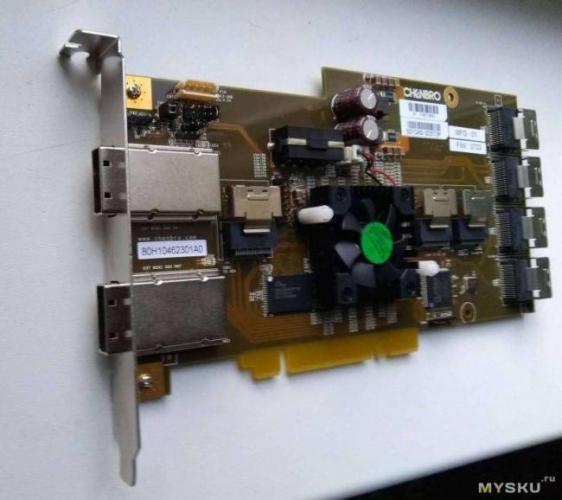

И еще есть отдельные дисковые корзины на 8 SFF дисков CSE-M28E1 и CSE-M28E2. Занимают 3 отсека 5.25″, имеют съемный вентилятор на задней стенке и 1 или 2 экспандера LSI SASX12. Интересной особенностью является подключение при помощи обычный SATA разъемов (по 4 на экспандера) и использованием нестандартных «перекрестных» кабелей 4xSAS->4 SATA. Сделано это потому, что два из четырех phy можно использовать не только на вход, но и на выход — для каскадирования. В комплекте идут два кабеля: с современными SFF-8087 разъемом и старым широким SFF-8484. Проблема номер один — кабели длиной 50см, такой длины хватает не всегда. Проблема номер два — несовместмость с SAS2 контроллерами, о чем уже упоминалось выше. Альтернативой является корзина M28SAB с обычным бэкплейном без экспандера. Вот и все. Задавайте дополнительные вопросы по почте и в комментариях, а за продукцией Supermicro, LSI и Adaptec обращайтесь в компанию True System.

- Цена: $9.00

Если дисков компьютере пара-тройка, подключение их простое. Но если дисков захотелось много — возникают особенности. На КДПВ SAS кабель с Али, уже проскакивавший в прошлом обзоре про ленту, так неожиданно тепло встреченным сообществом. Спасибо, камрады. Попробую затронуть тему, потенциально полезную чуть более широкому кругу. Хотя и специфическую. Начну с этого кабеля и обязательной программы, но только для затравки. Разные кусочки пазла приходится собирать в разных местах. Хочу сразу предупредить, что текст получился плотный и довольно тяжёлый. Заставлять себя читать и понять всё это уж точно не обязательно. Много картинок! Кто-то скажет, 9 баксов за тупой кабель? Что делать, в быту это применяется крайне редко, а на промышленные вещи тиражи ниже, а цены — выше. За сложный SAS кабель и сотню-другую баксов могут не моргнув глазом выставить. Так что китайцы ещё кратно снижают 🙂

Доставка и упаковка

Заказ 6 мая 2017, получено 17 мая — просто ракета. Трек был. Обычный серый пакет, внутри ещё один — вполне достаточно, товар не хрупкий.

Спецификация

Мама-папа SFF-8482 SAS 29 пин кабель. Длина 50 см Масса нетто 66 г Картинка продавца

Про SAS и SATA разъёмы

Что такое SFF-8482 и с чем его едят? Во-первых, это самый массовый разъём на SAS устройствах (Вика о SAS), например, на моём лентопротяге

А ещё SFF-8482 прекрасно садится на SATA диск (но не наоборот) Сравните, у SATA между данными и питанием промежуток. А у SAS он заполнен пластмассой. Поэтому SATA разъём на SAS устройство не налезет. Конечно, в этом есть смысл. По сигналам SAS и SATA разные. И SATA контроллер не сможет работать с SAS устройством. A SAS — контроллер сможет и с тем и с другим (хотя встречается совет не смешивать при определённых обстоятельствах, дома вряд ли реальных)

Сравните, у SATA между данными и питанием промежуток. А у SAS он заполнен пластмассой. Поэтому SATA разъём на SAS устройство не налезет. Конечно, в этом есть смысл. По сигналам SAS и SATA разные. И SATA контроллер не сможет работать с SAS устройством. A SAS — контроллер сможет и с тем и с другим (хотя встречается совет не смешивать при определённых обстоятельствах, дома вряд ли реальных)

SAS контроллеры и экспандеры

Ну и что, спросит читатель. Что я выигрываю от такой совместимости? Мне и SATA контроллеров достаточно! Истинная правда! Если достаточно — на этом месте можно нужно бросать читать. Вопрос был что делать, если МНОГО дисков? Вот так выглядит простенький SAS контроллер из моего зипа — DELL H200.

Корзины

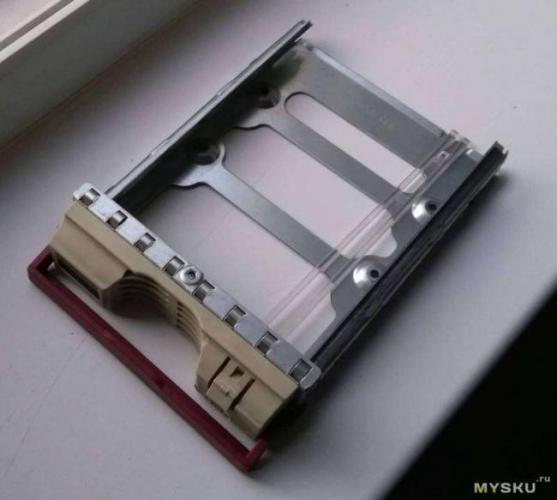

Понятно, диски прекрасно могут работать и без специальных корзин. Но иногда корзины могут быть полезны. Вот так выглядит SATA корзинка старой модели Супермикро. Можно найти за 1000 р, но скорее за 5+ тыс.

SAS+SATA у меня

Точнее работало до того, как мне понадобилось подключить лентопротяг. Первым делом я воткнул второй SAS контроллер, купил кабель miniSAS на sff 8482, примерно такой И включил. Всё заработало, но в режиме 24/7 каждый ватт стоит денег. Я искал переходники с sff 8482 на SATA, но решение оказалось ещё проще. Вы же помните, что SATA диск подключается на SAS sff 8482? Вот я теперь тоже помню, но тогда пару месяцев тупил 🙂 А потом вынул лишний контроллер, переключил один из дисков на чипсетный порт SATA порт, три остальных на sff 8482. Пришлось менять подключение питания, был разветвитель Molex-SATA, пришлось покупать на Али Molex-много Molex. Вот такойБрал здесь, всё хорошо. А лентопротяг переехал в другой корпус именно с использованием обозреваемого кабеля. Но это отдельная песня, а, караул, чувствую, устал 🙂

Где всё это выгоднее искать

Цены на новое серверное железо для дома запретительны. Так что бу, в том числе из ЗИП от выводимого из эксплуатации оборудования. Кабели можно найти на месте. За сравнимые деньги на e-bay. На Али — несколько менее вероятно, но бывают исключения — я же купил.Контроллеры — прежде всего на e-bay, причём из Европы. Можно из США, там сильно дешевле, если как-то решить вопрос с доставкой. Можно найти на Родине — авито. (На комке — дорого). В Китае покупать очень опасно. Множество жалоб на подделку из отбраковки. То работает, то нет. Никому ничего не докажешь.Корзины разумнее искать локально. Есть даже варианты простейшие корзины покупать новые. Простые корзины без электроники можно брать и в Китае и в Европе и на барахолке. Корзины с экспандерами — см пункт про контроллеры. ВАЖНО Запутаться — проще, чем потеряться в лесу. Консультируйтесь на форуме. SAS бывает разный -3, 6 и 12 Gb/s. Одни контроллеры шьются в то, что можно использовать с десктоп железом, другие нет, третьи вообще не заживут нигде, кроме матери родного производителя. И так далее.Конференция про NAS своими руками Конференция про SAS/SATA контроллеры и экспандеры На хоботе я MikeMac PS Если для вас это стало выступлением Капитана Очевидность — прошу прощения за отнятое время. Если бредом сивой кобылы — тем более мои искренние извинения. Трудно балансировать, хотелки, задачи и исходные у каждого свои. Да, про кабель же! Продавца рекомендую, кабелем доволен, доставка молниеносная. Используемые источники:

- https://habr.com/post/175313/

- http://true-system.blogspot.com/2011/09/sas.html

- https://mysku.ru/blog/aliexpress/54667.html

Сравнение жестких дисков SAS и SATA, корпоративных и настольных ПК...

Сравнение жестких дисков SAS и SATA, корпоративных и настольных ПК...

Что такое SATA 6 Гбит/с?

Что такое SATA 6 Гбит/с? Первое знакомство с Power eSATA

Первое знакомство с Power eSATA IDE SATA переходник – вторая жизнь для старых жестких дисков

IDE SATA переходник – вторая жизнь для старых жестких дисков Как подключить старый IDE HDD к SATA разъему

Как подключить старый IDE HDD к SATA разъему